这里梳理一下我目前比较感兴趣、以后可能做的研究方向,以及相关的论文、笔记、想法等。

Conference from: ICLR 2020

Paper link: [Open Review] [PDF]

目前的生成领域存在的一大问题就是在训练目标/损失函数/评估方法一侧,具体来说有以下几个问题:

Conference from: EMNLP 2019

Paper link: [PDF]

本文意图解决的是文本摘要任务。指针生成网络目前已经成为了目前的文本摘要模型的标准。然而指针生成网络往往受限于以下两个问题:

本文提出了一种模型,使得指针网络能够“编辑”其复制的词语,而不是简单地硬拷贝,来尝试解决上述问题。

Conference from: NIPS 2017

Paper link: [PDF]

在Transformer提出之前,在机器翻译或语言模型任务中用来建模序列的主流方法都是采用RNN,然而由于RNN的按时间步展开的特性,使得其无法并行化。此前,研究者们为了解决RNN的循环特性导致的不可并行化问题,提出了多种模型,包括ByteNet、ConvS2S等。然而这些模型都基于CNN,存在难以建模远距离依赖的问题。本文提出了Transformer结构,完全基于注意力来编码输入和计算输出,而不依赖于序列对齐的循环或卷积神经网络。

Conference from: ACL 2019

Paper link: Arxiv

Project page: Github

句子简化(Sentence Simplification)或文本简化(Text Simplification, TS)任务,意图在维持一个句子表义不变的情况下,降低该句子的复杂度,从而更好地帮助对该语言掌握程度较差的人(例如儿童、第二语言学习者)阅读。下面是几个句子简化任务的示例(摘自WikiSmall数据集)。

Conference from: AAAI 2019

Code: https://github.com/zysszy/GrammarCNN

本文拟解决的是代码生成(Code Generation)的任务,即:给定一段自然语言描述,模型自动生成代码片段。例如:给定描述“open the file, F1”,期望模型能自动生成Python代码:f = open('F1', 'r')。

与往常的使用RNN建模不同,本文使用CNN来提取输入特征。作者认为代码片段比传统的自然语言句子更长,因此RNN难以捕获长期依赖;而CNN能够通过滑动窗口捕捉到各个区域的特征,同时CNN具有效率高(可并行训练)、易收敛等特性。

作者提出本文是第一个成功地(完全)采用CNN来做代码生成任务的工作。

Conference from: ICLR 2019

Paper link: [OpenReview] [PDF]

Project page: http://nscl.csail.mit.edu/

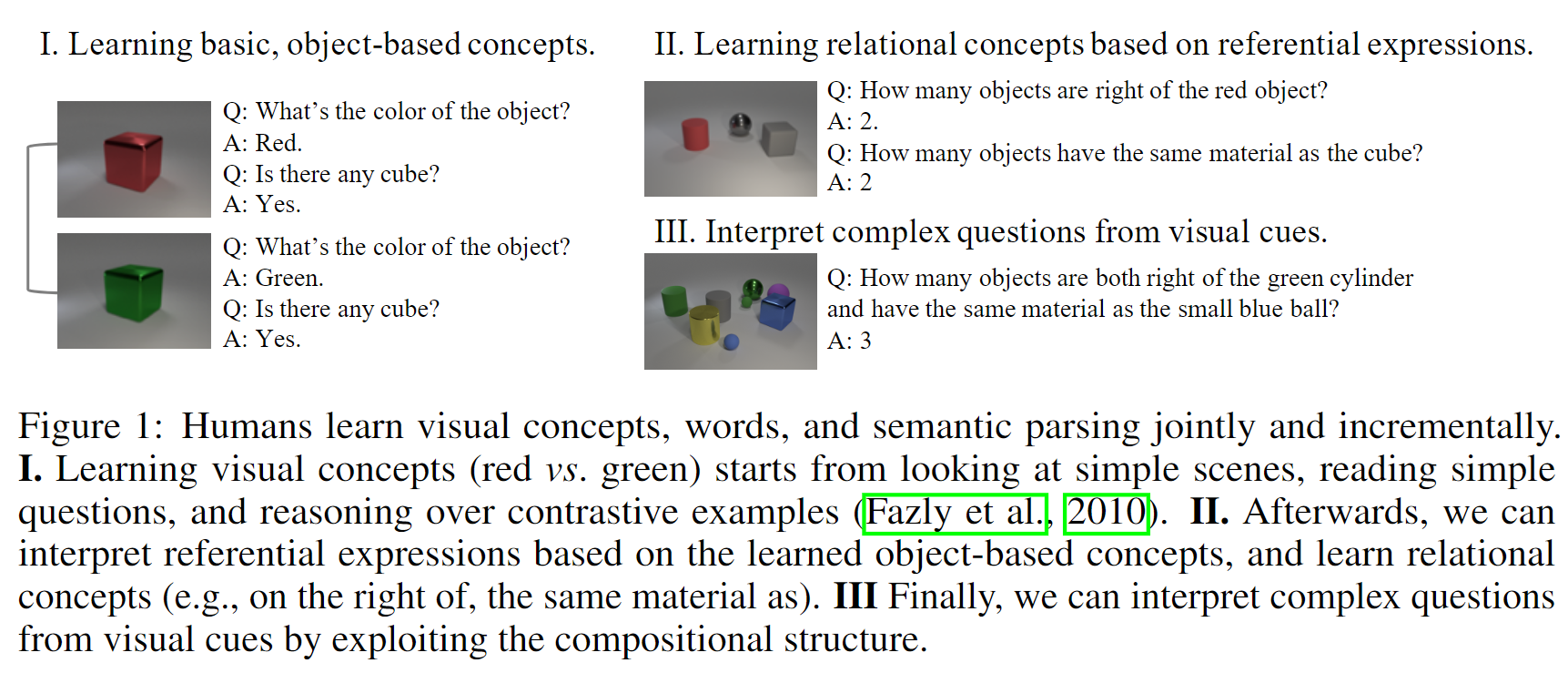

本文要解决的任务是看图问答任务(Visual Question Answering, VQA),如下图所示:

作者认为,人类可以通过看图片和问答对学习到视觉概念。如上图左半部分所示,想象一个没有“颜色”概念的人看到这两幅图时,他应该能识别出这两幅图在视觉呈现上的区别,并且与对应的问答对中的区别对应起来(Red vs Green)。由此从易到难进行训练,就可以在“视觉概念”和“对应的文本语义”之间建立起关联。

本文提出的方法只需要自然地使用配对了的图片、问题、答案三元组进行训练即可(就是论文题目中的Natural Supervision,自然监督)。